TabPFN: Die KI-Revolution für tabulare Daten

Predictive LLMs: Skalierung, Reproduzierbarkeit & DeepSeek

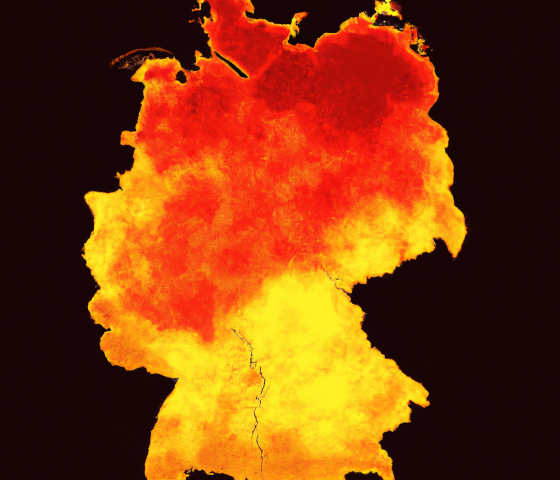

Bundestagswahl 2025: Evaluation der Wahlprognose

Predictive LLMs: Übertreffen Open-Source-Modelle OpenAI bei Preisprognosen?

Eine Einführung in das R-Paket kafka

XGBoost vs. LLMs für Predictive Analytics

Optimierung von Signalerkennung mittels Machine Learning

Predictive LLMs: Kann GPT-3.5 die Prognosen von XGBoost verbessern?

Business Case: ESG Reporting Plattform

Encoding in MariaDB/MySQL: Tipps zur Vermeidung von Encoding-Albträumen

Business Case: Echtzeit Fraud Detection Plattform

Business Case: Bayes'sches Prognosemodell für die Bundestagswahl

Business Case: Customized Stack zur automatisierten Luftschadstoffprognose in Berlin

Refactoring: Einführung

Erfolgsfaktoren für Data-Science-Projekte

Messen, Vergleichen, Optimieren: datengetriebene Entscheidungen mit A/B Testing

Interpretierbarkeit von KI-Modellen mit XAI

Wer ist der Klassenprimus? Unser Predictive Analytics Cube (PAC) macht Prognosemodelle vergleichbar

White Paper: Customer Lifetime Value

White Paper: Kundensegmentierung

White Paper: Attribution 2.0

White Paper: Automatische Content-Kuration für Presseportale

Die Welt der Container: Einführung in Docker

Pandas DataFrame Validierung mit Pydantic - Teil 2

Bundestagswahl 2021: Wie gut waren unsere Wahlprognosen?

Pandas DataFrame Validierung mit Pydantic

Verstehen wie unsere Kunden Kaufentscheidungen treffen Discrete-Choice-Modelle mit RStan

Code-Performanz in R: Mit großen Datensätzen arbeiten

Code-Performanz in R: Parallelisierung

Wie man einen Twitter Bot zum Crawlen von Website-Grafiken automatisiert

Code-Performanz in R: Warum ist mein Code langsam

Code-Performanz in R: R-Code beschleunigen

Verstehen wie unsere Kunden Kaufentscheidungen treffen: Discrete Choice-Modelle im Marketing

Die Darstellung der Corona-Infektionszahlen in Raum und Zeit

COVID-19 - Karte der lokalen 7-Tage-Inzidenz im Zeitverlauf

Reflektion der US-Wahlprognose 2020 - 10 Dinge, die Data Scientists wissen sollten

Churn Analyse zur Gewinnung und Bindung wertvoller Kunden

Python Weihnachtsdekoration

Schützen Sie Ihre Datenbank vor SQL Injections

Reinforcement Learning für Marketing: Lektionen und Herausforderungen

Continuous Integration: Einführung in Jenkins

Continuous Integration: Was es ist, warum es wichtig ist und Tools für den Einstieg

Fehlende Werte Verstehen und Handhaben

shinyMatrix - Eingabefeld für Matrizen in Shiny

Aufbau eines starken Data Science-Teams von Grund auf

Datenvisualisierung: R vs. Python

Debuggen in R: So können Sie Fehler in Ihrem Code einfach und effizient beheben

Marketing Mix Modeling - Wie wirkt Werbung wirklich?

Multi-Armed Bandits als Alternative zum A/B-Test

Datenqualität und die Bedeutung von Data Stewardship

Best Practice: Entwicklung robuster Shiny Dashboards als R-Pakete

Shiny Module

rsync als R-Paket

Module in R

ggCorpIdent: ggplot2-Grafiken im Corporate Design gestalten

Ein nicht ganz so einfaches Balkendiagramm mit ggplot2

R Markdown Template für Business Reports

Eine sinnvolle Dateistruktur für R-Projekte

INWT-Guidelines für R-Code

Fussball-WM 2018 - Konnte unsere INWT Prognose punkten?

Prognose - Wer gewinnt die WM 2018?

Python für R-Programmierer

Checkliste für die Anschaffung von Statistik-Software

Der flexible Allrounder in Data Science - Python

Die mächtige Open Source-Lösung - R

Statistik-Software - R, Python, SAS, SPSS und STATA im Vergleich

Der Mercedes unter den Statistik-Programmen - SAS

Statistik zum Klicken - SPSS

Mehr als nur Panel-Analysen - STATA

Business Case: Predictive Customer Journey (PCJ)

Business Case: Spillover-Analyse

Business Case: Kundensegmentierung

Business Case: Datenvisualisierung

Bundestagswahl 2017: Die Würfel sind gefallen

Text Mining – Part 3: Making-Of

Text Mining – Part 1: Analyse der Wahlprogramme für die BTW 2017

Text Mining – Part 2: Making-Of

Welche Koalition wird Deutschland nach der Bundestagswahl regieren?

Automatisierte Excel-Reports mit Python

Wer gewinnt die Bundestagswahl 2017?

MariaDB-Monitor

Business Case: Qualitätsindex

Business Case: Einsatzplanung im Personalwesen

Business Case: Customer Lifetime Value (CLV)

Business Case: Kreditkartenbetrug erkennen

Business Case: Attribution 2.0

Business Case: TV Impact

Clusteranalyse in R

Clusteranalyse: Einführung

Logistische Regression - Beispiel in R

Logistische Regression - Beurteilung der Klassifikationsgüte

Logistische Regression - Modell und Grundlagen

Big Data - Erfolgsgeschichten

Big Data - nur Gewinner?

Big Data richtig nutzen

Best Practice TV-Tracking: Warum eine einfache Baseline-Korrektur zu kurz greift!

Fragebogenkonstruktion: 20 Tipps für einen besseren Fragebogen

Fragebogenkonstruktion: Die häufigsten Fehler

Beispielregression: Zunge vs. Zahlen